一、人工智能治理框架

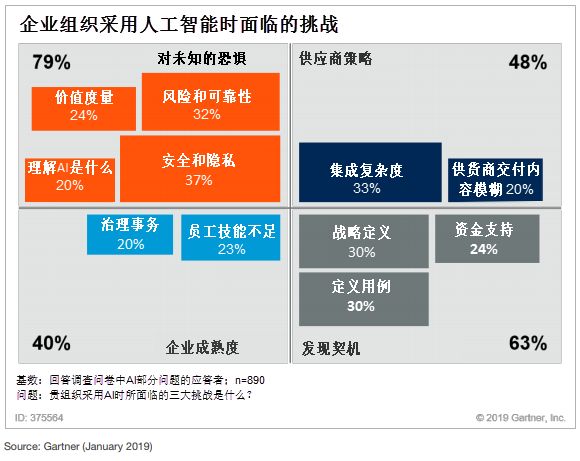

在企业可能部署AI之前,数据和分析部门的领导者就应了解人工智能治理,需要在人工智能的应用价值与技术带来的合规及商誉风险之间进行权衡,他们将面临的障碍如图1所示。

图1:企业组织采用人工智能时面临的挑战

人工智能治理(AI governance)是指企业应用AI技术时,在组织职责、决策权限、风险管控、政策支持和投资决策等领域所采取的分配和保障过程。

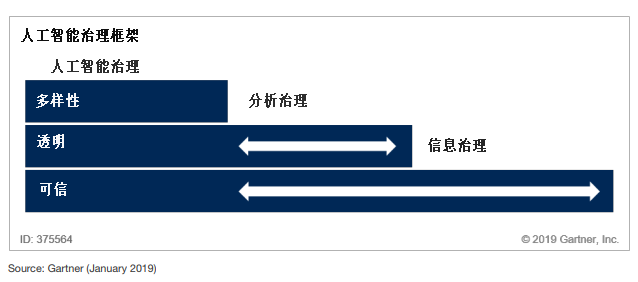

Gartner人工智能治理框架如图2所示,人工智能系统迥异于传统系统,一是要自底向上构建,二是人工智能系统存在三难点:选择训练数据集带来机器学习的困局(要有多样性)、决策精度差异(结果是否可解释并可信)和恰到好处的可接受结果,其治理应基于信息治理和分析治理,需将信息治理和分析治理扩展到人工智能的专有领域。

图2:人工智能治理框架

二、聚焦可信度,促进人工智能应用

人们不愿接受人工智能的原因是缺乏信任,一般对人工智能的态度,介于“完全信任不准确的解决方案”到“完全不信任准确的解决方案”之间。但要明白,人工智能的输出有可能不正确,但其多数结果还是有用的。

报告建议从人、数据和算法三个维度提升人工智能的可信度。

(1)人:工作组成员的多样化不仅赢得信任,还能提出解决问题的新思路。多加比较,选择一个恰当、有效的人工智能工具或解决方案,避免那些“旧瓶装新酒”的“AI”。

(2)数据:在完全可信数据和基本不可信数据之间定义数据的可信度,如,已知含有偏见的数据及来自某些特定第三方的数据,可定为低可信度数据。应当谨慎使用,但不要直接排斥低可信度数据。

(3)算法:源算法和训练模型可能来源于数据科学小组、外部咨询专家、商业平台、开源库,以及能够生成模型的服务或者APIs,不同来源的可信度也各不相同。

三、审视透明度,减少人工智能应用风险

人工智能透明度的核心问题在于如何权衡结果的准确性和可解释性,是否应该“透明但不准确”亦或“黑盒但精确”呢?报告同样基于人、数据、算法三个维度来剖析人工智能的透明度。

(1)人:应当要求文档和代码的透明性,确保本企业使用的模型可理解,而不单单是撰写者明白。对于受众关心的人工智能系统是如何得出特定结论,需要有合理的解释,当然“可解释性”并不一定是具备深层次的科学意义,但至少应分析出基本风险,涵盖AI用户关心的问题。

(2)数据:诸如数据存储在哪里、谁可以访问数据、如何确保数据安全,以及当敏感数据被系统大声读出时意味着什么。要实现数据的透明度,首要任务是制定协作、数据准备、元数据、可视化工具的标准。

(3)算法:可通过“玻璃盒”设计,或在开发后通过文档、测试和验证预测模型中最复杂的类型等方法来提高透明度。治理对于算法的精确度、简化度、伸缩性、可读性及易于理解性都有一定的要求。

四、在人、数据和算法三维度保持多样性,确保人工智能符合伦理、结果精准

数据、算法,以及选择数据和算法的人,都可能存在偏见,而多样性是防止偏见的良方,也同样可在这三个维度来构筑多样性:

(1)人:均衡的团队通常由不同专长的人组成,如各种技能、知识领域、经验、年龄、性别、文化、种族、道德观等,都可以带来独特视角,可重塑AI解决和验证问题的能力,也可帮助团队成员学习新技能。

(2)数据:数据多样化不仅对传统数据管理模式进行颠覆,也意味着结构化与非结构化数据的融合,需要信息治理进行适度调整。一般信息不足将会削弱结果的有效性。但在某些情况下,可能出于隐私保护的原因而无法收集数据,因此要习惯于“信息不足”,及早采取措施弥补数据不足的缺憾。

(3)算法:单一算法或固定算法集通常无法满足人工智能项目中的复杂性要求,但混用多种决策模型时,输出结果可能相互矛盾。实际上,要提高人工智能的准确性、确保符合伦理,并促进人工智能应用,就应当要有意地让结果多样化的,让用户自己去选择他所认为的最佳结果。

本文由赛博研究院出品,转载请注明:本文来源于赛博研究院官网。

更多精彩内容请关注“赛博研究院”公众号。